VMware 替换关键技术:核心业务系统中,访存密集型应用的性能优化

越来越多用户采用虚拟化、超融合以及云平台环境来承载其核心业务,核心业务的高并发对性能的要求尤为严格,在 VMware 替换的热潮下,原 VMware 用户也更为关注新平台在核心业务上的性能表现是否对标,或实现超越。深信服(300454)将通过系列解析,为大家从不同维度分享提升平台性能的关键技术。

在当前用户的核心业务系统中,访存密集型应用越来越多,如金融行业的高频交易系统、风险管理系统; 医疗行业的电子健康记录 (EHR) 系统、物流行业的仓库管理系统等。这些系统对于访存要求的提升,与其后端使用了很多如分布式缓存 Redis、大数据处理引擎 Spark,分析型数据库 HANA、AI 引擎 / 模型等服务组件有很大关系。以 Redis 为例,其为内存型数据库,内存访问速度会直接影响其性能表现。

NUMA 作为当前主流的服务器 CPU 架构,在 NUMA 架构下,如何提升访存速度是虚拟化性能优化的重要课题之一。本文将详细解析深信服在 NUMA 架构优化方面的技术,展示如何通过这些技术提升虚拟化平台的性能,满足用户核心业务高并发运行的要求,以及在 VMware 替代过程中的性能需求。

NUMA 架构背景

在早期的计算机系统中,通常只有一个处理器用于执行所有的计算任务。然而,随着计算机应用的复杂性和需求的增加,单个处理器无法满足高性能计算的要求,计算机系统逐渐向多核架构演进。

传统的多核方案采用的是 SMP (Symmetric Multi-Processing) 技术,即对称多处理器结构。在 SMP 架构下,每个处理器的地位都是平等的,对内存的使用权限也相同。任何一个线程都可以分配到任何一个处理器上运行,在操作系统的支持下,可以达到非常好的负载均衡,让整个系统的性能、吞吐量有较大提升。但是,由于多个核使用相同的总线访问内存,随着核数的增长,总线将成为瓶颈,制约系统的扩展性和性能。

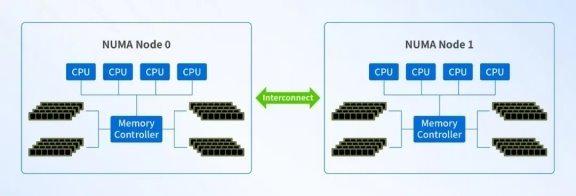

NUMA 架构可以很好地解决 SMP 架构的内存访问瓶颈问题。在 NUMA 架构中,系统被划分为多个节点,每个节点包含一个或多个处理器、本地内存和 I/O 设备。节点之间通过高速互连网络进行通信,如 HyperTransport (AMD) 或 QuickPath Interconnect (Intel) 等,使处理器优先访问本地内存,降低内存访问延迟,提高了多处理器系统的性能。

在 NUMA 中有三种节点类型:

· 本地节点:对于某个节点中的所有 CPU,此节点称为本地节点。

· 邻居节点:与本地节点相邻的节点称为邻居节点。

· 远端节点:非本地节点或邻居节点的节点,称为远端节点。

CPU 访问不同类型节点内存的速度是不相同的,访问本地节点的速度最快,访问远端节点的速度最慢,即访问速度与节点的距离有关,距离越远访问速度越慢。

Christoph Lameter 博士在《NUMA: An Overview》一文中指出:2013 年,高端商用服务器有两个 NUMA 节点,本地节点的随机内存访问时延为 100ns 左右,远端节点的内存访问时延需要增加 50%。

NUMA 引入挑战

在 linux 系统中,线程作为 CPU 调度的基本单位,对应 CPU 运行队列上的一个任务。内核会为每个任务选择一个相对空闲的 CPU,但 CPU 的负载是动态的,内核实现了 CPU 的 Load Balance 机制,会往相对空闲的 CPU 上迁移任务。也就是说,默认情况下,任务可能在不同的 CPU 之间迁移。

在 NUMA 架构下,任务可能从 Node 1 上的 CPU 迁移到 Node 2 上的 CPU,任务访问之前 Node1 上的内存数据,会造成跨节点 CPU 访问。虽然 linux 内核提供了 NUMA Balance 机制,周期性的迁移任务或者内存数据到本地节点,尽可能地让任务访问本地节点的内存,但无法 100% 避免远端内存的访问。

在虚拟化场景下,一个虚拟机的 vCPU 对应操作系统上一个线程 (如下图),多个 vCPU 线程运行在不同 NUMA 节点上共享内存,或者 vCPU 线程在不同 NUMA 节点之间迁移,都会导致虚拟机跨 NUMA 节点访问,内存访问延迟增加。

业界 NUMA 调度技术机制

针对 NUMA 特性,业界主要有以下几种常见方案:

方案 1:vCPU 绑定物理核

需要手动设置 vCPU 绑定,vm 资源优先绑定在物理机的同一个 NUMA Node 上。

方案 2:指定虚拟机绑定的 NUMA 节点数量

手动配置绑定的 NUMA 节点数,会将 vCPU 和内存平均分配到相应数量的 NUMA 节点上。

方案 3:自适应分配 NUMA 节点

调度程序会为虚拟机自动分配 NUMA 节点,虚拟机的 CPU 会被限制在 NUMA 节点上运行,优先使用本地内存,提高内存局部性。虚拟机的 vCPU 个数可能超过 NUMA 节点核的数量,单个 NUMA 节点无法容纳,会被分配到多个 NUMA 节点。为了提高内存局部性,支持将 NUMA 拓扑暴露给虚拟机,由虚拟机做最佳决策。同时在 NUMA 节点间迁移云主机,保证节点间的 Load Balance。

从使用上看,方案 1、2 限制较多,使用上不是很方便,对 VM 的 CPU 数量有要求,并且静态绑定可能导致 NUMA 节点间负载不均衡。因此,方案 3 比较常见。

深信服 NUMA 调度技术详解

深信服超融合主要采用自适应的 NUMA 调度,自适应 NUMA 调度能够做到 NUMA 之间的负载均衡,同时减少 vCPU 远程内存访问,提升整体的性能。

自适应的 NUMA 调度在不同类型应用中优化效果明显,特别对于一些内存操作的中间件。我们在虚拟机中分别部署 DM8 (达梦数据库)、Redis 和 memcache,分别在开启和关闭 NUMA 调度的场景下执行基准测试。从测试数据看,开启 NUMA 调度后,中间件性能明显提升。

BenchmarkSQL 是一个关系型数据库的基准测试工具,通过对数据库进行 TPC-C 标准测试,即模拟多种事务处理:新订单、支付操作、订单状态查询、发货、库存状态查询等,从而获得最终的 tpmC 值。tmpC 表示每分钟可以处理多少个新订单,值越大代表性能越好。通过 BechmarkSQL V5.0 来对达梦数据库 dm8 运行基准测试。

下图表示启用 NUMA 调度对应用的相对性能改进,Y 轴的 100% 表示关闭 NUMA 调度测出来的 tmpC 指标权重。

redis-benchmark 是 Redis 官方提供的性能测试工具,我们通过 redis-benchmark 对 Redis V7.2.5 进行压测,在关闭 / 开启 NUMA 调度场景下,分别测试 SET / GET 长度为 1KB 的 value 的 QPS 指标。QPS 表示每秒的读写操作数。

测试命令及参数:

redis-benchmark -t get -d 16 -c 100 -n 6000000 -r 60000000

redis-benchmark -t set -d 16 -c 100 -n 6000000 -r 60000000

下图表示启用 NUMA 调度对应用的相对性能改进,Y 轴的 100% 表示关闭 NUMA 调度测出来的 QPS 指标权重。

memaslap 是 Memcache 自带的性能测试工具,我们通过 memaslap 对 Memcache V6.27 压测,在关闭 / 开启 NUMA 调度场景下,分别测试 value 长度为 1kb 的 TPS 值。TPS 表示每秒事务数。

测试命令及参数:

memaslap -s 127.0.0.1:11211 -t 300s -T 8

下图表示启用 NUMA 调度对应用的相对性能改进,Y 轴的 100% 表示关闭 NUMA 调度测出来的 TPS 指标权重。

从上面的测试数据看,对于访存密集型应用优化效果比较明显。以下为具体实现原理。

1、自适应分配 NUMA 节点

自适应地将虚拟机的 vCPU 进行划分后调度到 NUMA 节点,减少虚拟机 vCPU 远程内存访问。如图,自动为虚拟机选择合适的 NUMA 节点,当虚拟机 vCPU 数量小于 NUMA Node 的核数时,则将调度到一个 NUMA 节点上。当虚拟机 vCPU 数量大于 NUMA 节点的核数时,则将调度到多个 NUMA Node 上,同时会将 vNUMA 拓扑暴露给虚拟机,由虚拟机做出最佳决策。

为了保证 NUMA 节点的负载均衡,在放置虚拟机时,会考虑 NUMA 节点间的负载情况,选择一个负载较低的节点。同时,在虚拟机运行过程中,结合 NUMA 节点负载,会对虚拟机在 NUMA 节点之间进行迁移。优先保障重要虚拟机所在 NUMA 节点负载更低,能够避免 CPU、内存带宽以及 Cache 资源的相互抢占。

2、信创场景优化

信创服务器 NUMA 节点多,NUMA 间的距离也不一致,NUMA 节点的核数也相对较少。

针对信创服务器的 NUMA 特点,我们会识别 NUMA 节点之间的距离,优先将同一个虚拟机多个 vNUMA 放置到相近的 pNUMA 上。

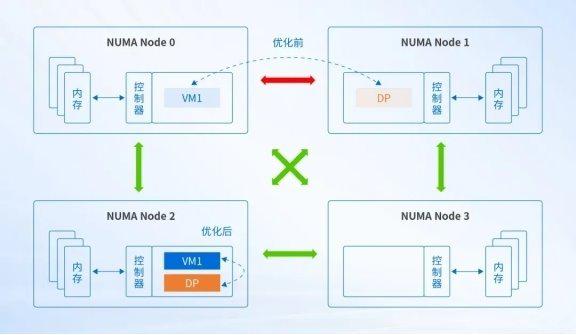

为了进一步在信创场景下提高数据转发性能,深信服为底层虚拟化设计开发 NUMA 亲和性功能,即对虚拟机和数据转发进程进行强关联,调度到同一个 NUMA 节点上,使用本地内存访问,提高数据转发的性能。如图,DP 为数据转发进程。

为了最大程度发挥 NUMA 的优势,在存储层面将一条完整 IO 上的 vCPU、qemu、libnfs、aSAN 等进程调度到同一个 NUMA Node (如下图),避免内存远端数据访问,并使用大页内存机制提高访存性能,降低数据处理过程中的开销,提升 IO 流处理效率。

数据在从网卡缓存区传输到虚拟存储的过程中,需要经过各自的 CPU 线程进行处理。而随着网卡性能提升,单核 CPU 缓存转存的效率成为瓶颈,且跨 NUMA 的远端访问也会降低效率。让网卡可以被多个 CPU 进行处理,同时对其进行 NUMA 亲和,既打破了缓存转存的瓶颈,也可以降低传输延迟,更大程度地提升并发性能,提升虚拟机高深度大块写性能 20% 以上。

3、与业界方案的对比分析

行业支持情况:

H 厂商支持在页面上配置虚拟机每个 vCPU 运行到哪个 NUMA 节点;S 厂商不支持;VMware 支持自适应 NUMA 调度。

深信服平台自适应将虚拟机的 vCPU 进行划分后放置到 NUMA 节点,减少虚拟机 vCPU 远程内存访问。相比页面配置每个 vCPU 运行位置,深信服自适应 NUMA 调度能够自动进行虚拟机 vCPU 的划分和放置,并且在 NUMA 之间进行均衡,减少 vCPU 远程内存访问,提升整体的性能。

相比 VMware,深信服通过创新研究院和云产品线的合作研究,深度结合我们自己的业务场景以及平台服务情况,增加了存储服务的 NUMA 调度、重要虚拟机识别、信创场景适配、虚拟机网络亲和等,提升调度效果。

总结

深信服的 NUMA 自适应调度基于各场景做了深度适配优化,进一步提升应用的内存访问速度:

· 自适应将虚拟机的 vCPU 进行划分后放置到 NUMA 节点,减少虚拟机 vCPU 远程内存访问。

· 在不同的 NUMA 节点之间进行迁移,保障 NUMA 节点之间负载均衡。

· 识别重要虚拟机,保障重要虚拟机所在 NUMA 节点负载更低,能够避免 CPU、内存带宽以及 Cache 资源的相互抢占。

· 针对信创服务器多 NUMA 且 NUMA 间距离不一样的场景,增加了识别 NUMA 节点之间的距离,优先将同一个虚拟机多个 vNUMA 放置到相近的 pNUMA 上。

· 支持虚拟机网络亲和选项,勾选后将虚拟机调度到和网络数据面相同的 NUMA 节点,提高数据转发的性能。

· 不仅对虚拟机进行 NUMA 调度,对存储服务也会进行相应的 NUMA 调度。

UnixBench 测试实例

UnixBench 是一个广泛使用的基准测试工具,用于评估类 Unix 系统 (包括 UNIX、BSD 和 Linux) 的性能。它通过一系列测试来衡量系统的各种性能指标,如 CPU、文件系统、内存和进程等。

测试环境说明:

测试结果:

在落地版本 HCI 6.9.0 中,我们能达到如下效果。在后续版本的优化中,我们仍持续保持该项技术效果的领先。

超融合启用 NUMA 时,UnixBench 测试结果如下:

同主机六台虚拟机结果相较于 S 厂商高出 20.2%,同主机八台虚拟机得分相较于 S 厂商高出 34.17%。

0人